Nvidia a dévoilé sa plateforme GPU d’IA de nouvelle génération, nommée « Blackwell », lors de sa keynote GTC 2024 à San Jose, en Californie.

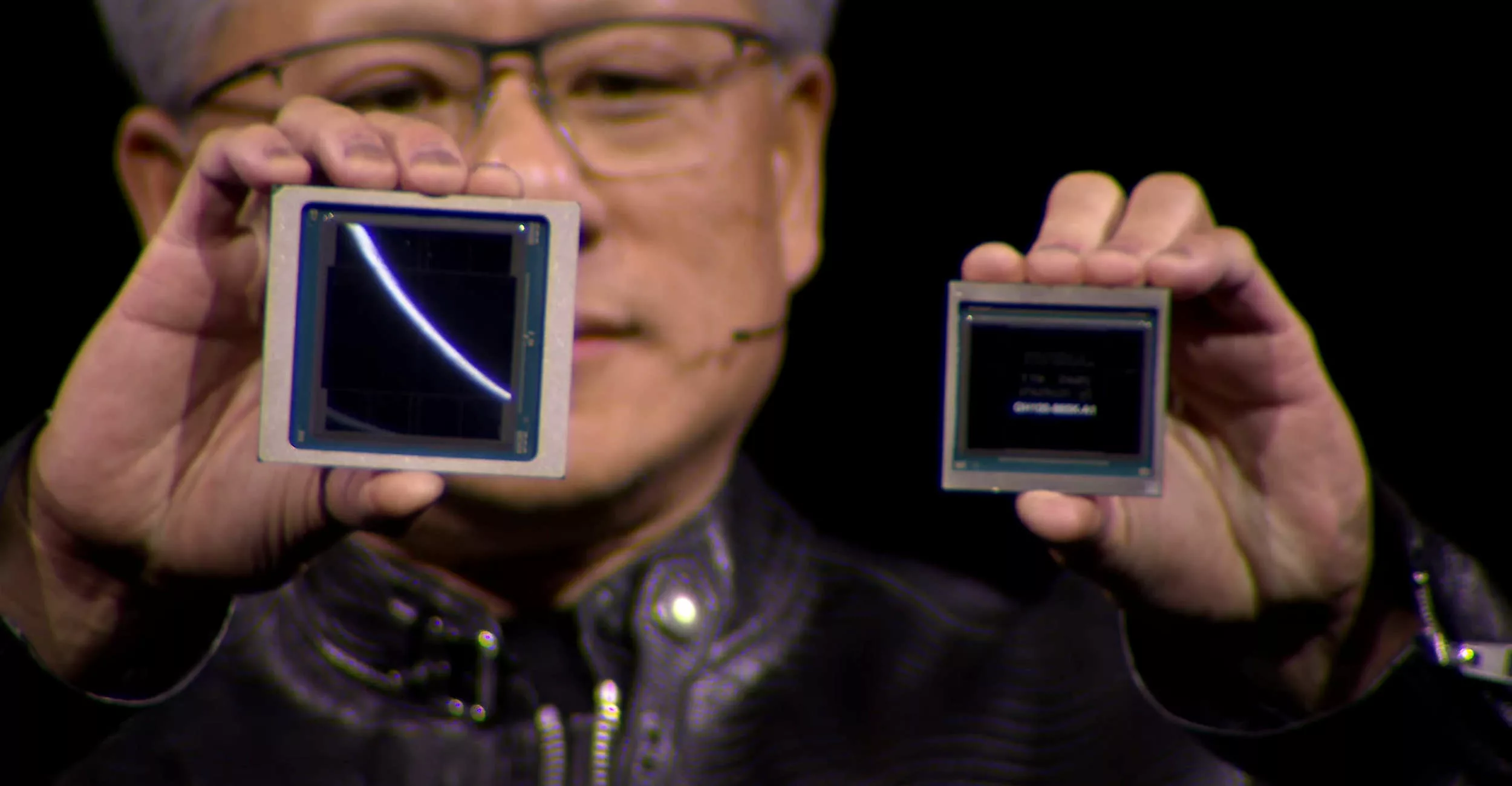

Cette puce de pointe est fabriquée en connectant deux matrices de semi-conducteurs fabriquées selon le processus 4 nanomètres de TSMC à Taïwan, avec 280 milliards de transistors. Les deux matrices fonctionnent comme une seule puce, échangeant 10 téraoctets (To) de données par seconde.

Le GPU Blackwell a été nommé en l’honneur de David Harold Blackwell (1919-2010), un mathématicien américain du XXe siècle qui a établi la théorie des jeux, la théorie des probabilités, la théorie de l’information, etc. Selon Jensen Huang, PDG de Nvidia, « Nous avons besoin de GPU plus puissants pour apprendre et imiter des textes, des images, des graphes et même des vidéos dans les langues du monde entier ».

La puce Blackwell est dotée de fonctions intégrées telles que le NVLink de 5e génération, une voie de connectivité qui peut envoyer et recevoir 1,8 To de données par seconde dans les deux sens entre jusqu’à 576 GPU, un moteur RAS alimenté par l’IA qui valide la fiabilité du GPU, et Secure AI qui chiffre les données sensibles et garantit leur authenticité.

Nvidia a également présenté le GB200, composé de deux GPU Blackwell et d’un processeur Grace. Le GB200 NVL72 est capable d’effectuer 1,4 exaflops par seconde de calcul IA et dispose de 30 To de mémoire HBM3e. Avec ce système, Nvidia affirme avoir amélioré les vitesses de traitement LLM (large language model) jusqu’à 30 fois par rapport à un système traditionnel de 36 H100.

En plus de cela, Nvidia a lancé le HGX B200, un accélérateur qui peut utiliser les processeurs x86 existants tels que Intel Xeon et AMD Epic. Il comprend huit GPU TensorCore B200 et utilise le réseau Ethernet Quantum2 de Nvidia pour transférer des données à une vitesse pouvant atteindre 400 Gbps par seconde.

La puce Blackwell devrait être disponible dans le courant de l’année. Les principaux fournisseurs de serveurs, dont Cisco, Dell Technologies, HPE, Lenovo et Supermicro, proposeront également des serveurs basés sur Blackwell. En plus de son propre cloud DGX, Nvidia proposera des instances Blackwell par l’intermédiaire des principaux fournisseurs de cloud du monde entier, notamment Amazon Web Services (AWS), Google Cloud et Microsoft Azure.